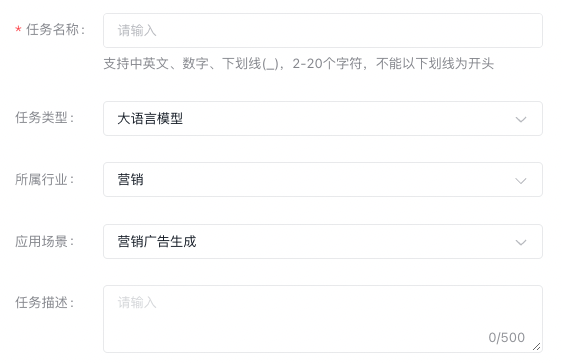

创建 SFT 任务

创建任务

大语言模型

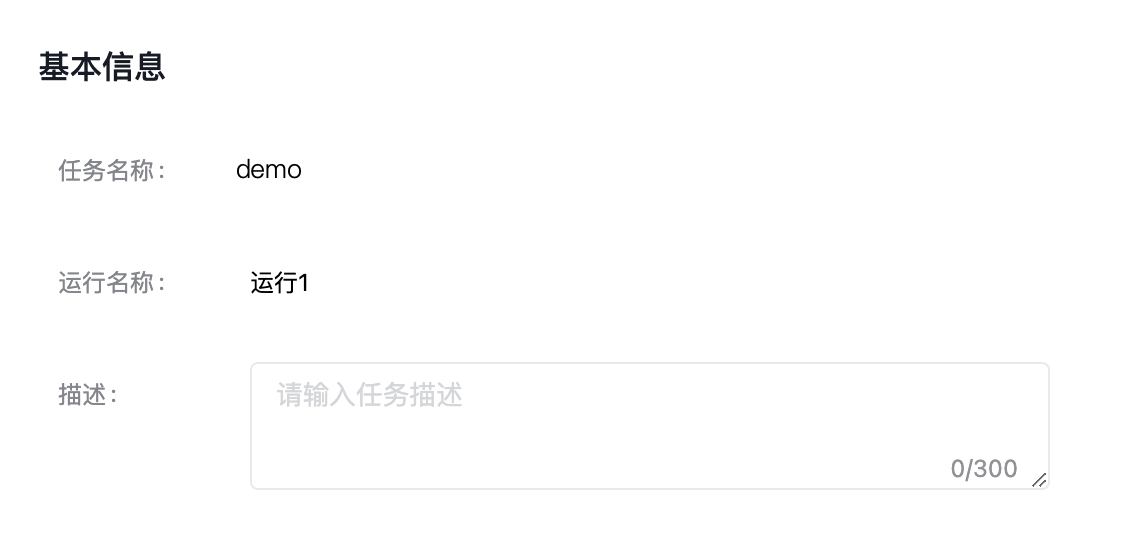

新建运行

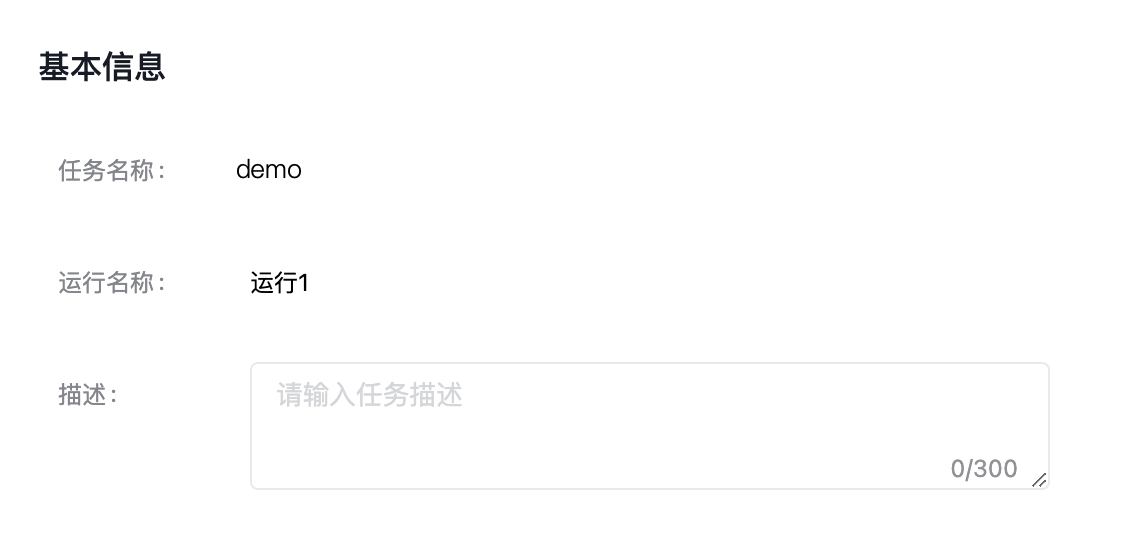

进入模型训练的任务运行配置页,填写基本信息。

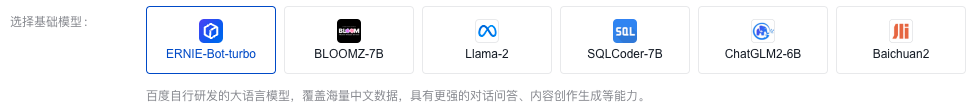

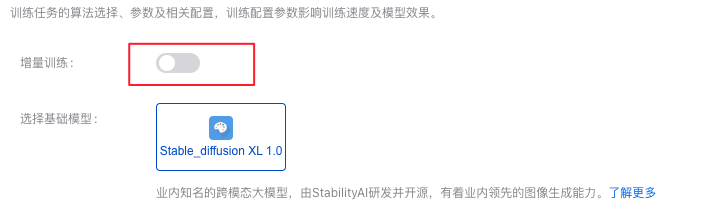

训练配置

开关打开后,需要选择SFT的基准模型,此模型来源于运行中的SFT任务。所以您开启增量训练任务的前提有已经在运行中的SFT任务。

·ERNIE-Bot-turbo

ERNIE-Bot-turbo-0725

| 训练方法 | 简单描述 |

|---|---|

| 全量更新 | 全量更新在训练过程中对大模型的全部参数进行更新 |

| LoRA | LoRA在固定预训练大模型本身的参数的基础上,在保留自注意力模块中原始权重矩阵的基础上,对权重矩阵进行低秩分解,训练过程中只更新低秩部分的参数。 |

| 超参数 | 简单描述 |

|---|---|

| 迭代轮次 | 迭代轮次(epoch),控制训练过程中的迭代轮数。 |

| 学习率 | 学习率(learning_rate)是在梯度下降的过程中更新权重时的超参数,过高会导致模型难以收敛,过低则会导致模型收敛速度过慢,平台已给出默认推荐值,可根据经验调整。 |

| 序列长度 | 单条数据的长度,单位为token。如果数据集中每条数据的长度(输入)都在4096 tokens 以内,建议选择4096,针对短序列可以达到更优的训练效果。 |

ERNIE-Bot-turbo-0704

| 训练方法 | 简单描述 |

|---|---|

| 全量更新 | 全量更新在训练过程中对大模型的全部参数进行更新 |

| Prompt Tuning | Prompt Tuning在固定预训练大模型本身的参数的基础上,增加prompt embedding参数,并且训练过程中只更新prompt参数。 |

| LoRA | LoRA在固定预训练大模型本身的参数的基础上,在保留自注意力模块中原始权重矩阵的基础上,对权重矩阵进行低秩分解,训练过程中只更新低秩部分的参数。 |

| 超参数 | 简单描述 |

|---|---|

| 迭代轮次 | 迭代轮次(epoch),控制训练过程中的迭代轮数。 |

| 学习率 | 学习率(learning_rate)是在梯度下降的过程中更新权重时的超参数,过高会导致模型难以收敛,过低则会导致模型收敛速度过慢,平台已给出默认推荐值,可根据经验调整。 |

ERNIE-Bot-turbo-0516

| 训练方法 | 简单描述 |

|---|---|

| 全量更新 | 全量更新在训练过程中对大模型的全部参数进行更新 |

| 超参数 | 简单描述 |

|---|---|

| 迭代轮次 | 迭代轮次(epoch),控制训练过程中的迭代轮数。 |

| 批处理大小 | 批处理大小(BatchSize)表示在每次训练迭代中使用的样本数。较大的批处理大小可以加速训练,但可能会导致内存问题。 |

| 学习率 | 学习率(learning_rate)是在梯度下降的过程中更新权重时的超参数,过高会导致模型难以收敛,过低则会导致模型收敛速度过慢,平台已给出默认推荐值,可根据经验调整。 |

·BLOOMZ-7B

| 训练方法 | 简单描述 |

|---|---|

| 全量更新 | 全量更新在训练过程中对大模型的全部参数进行更新 |

| Prompt Tuning | 在固定预训练大模型本身的参数的基础上,增加prompt embedding参数,并且训练过程中只更新prompt参数。 |

| LoRA | 在固定预训练大模型本身的参数的基础上,在保留自注意力模块中原始权重矩阵的基础上,对权重矩阵进行低秩分解,训练过程中只更新低秩部分的参数。 |

| 超参数 | 简单描述 |

|---|---|

| 迭代轮次 | 迭代轮次(epoch),控制训练过程中的迭代轮数。 |

| 批处理大小 | 批处理大小(Batchsize)表示在每次训练迭代中使用的样本数。较大的批处理大小可以加速训练,但可能会导致内存问题。 |

| 学习率 | 学习率(learning_rate)是在梯度下降的过程中更新权重时的超参数,过高会导致模型难以收敛,过低则会导致模型收敛速度过慢,平台已给出默认推荐值,可�根据经验调整。 |

Llama-2

Llama-2-7b

| 训练方法 | 简单描述 |

|---|---|

| 全量更新 | 全量更新在训练过程中对大模型的全部参数进行更新 |

| Prompt Tuning | 在固定预训练大模型本身的参数的基础上,增加prompt embedding参数,并且训练过程中只更新prompt参数。 |

| LoRA | 在固定预训练大模型本身的参数的基础上,在保留自注意力模块中原始权重矩阵的基础上,对权重矩阵进行低秩分解,训练过程中只更新低秩部分的参数。 |

| 超参数 | 简单描述 |

|---|---|

| 迭代轮次 | 迭代轮次(epoch),控制训练过程中的迭代轮数。 |

| 批处理大小 | 批处理大小(Batchsize)表示在每次训练迭代中使用的样本数。较大的批处理大小可以加速训练,但可能会导致内存问题。 |

| 学习率 | 学习率(learning_rate)是在梯度下降的过程中更新权重时的超参数,过高会导致模型难以收敛,过低则会导致模型收敛速度过慢,平台已给出默认推荐值,可根据经验调整。 |

Llama-2-13b

| 训练方法 | 简单描述 |

|---|---|

| 全量更新 | 全量更新在训练过程中对大模型的全部参数进行更新 |

| Prompt Tuning | 在固定预训练大模型本身的参数的基础上,增加prompt embedding参数,并且训练过程中只更新prompt参数。 |

| LoRA | 在固定预训练大模型本身的参数的基础上,在保留自注意力模块中原始权重矩阵的基础上,对权重矩阵进行低秩分解,训练过程中只更新低秩部分的参数。 |

| 超参数 | 简单描述 |

|---|---|

| 迭代轮次 | 迭代轮次(epoch),控制训练过程中的迭代轮数。 |

| 批处理大小 | 批处理大小(Batchsize)表示在每次训练迭代中使用的样本数。较大的批处理大小可以加速训练,但可能会导致内存问题。 |

| 学习率 | 学习率(learning_rate)是在梯度下降的过程中更新权重时的超参数,过高会导致模型难以收敛,过低则会导致模型收敛速度过慢,平台已给出默认推荐值,可根据经验调整。 |

·SQLCoder-7B

| 训练方法 | 简单描述 |

|---|---|

| 全量更新 | 全量更新在训练过程中对大模型的全部参数进行更新 |

| LoRA | 在固定预训练大模型本身的参数的基础上,在保留自注意力模块中原始权重矩阵的基础上,对权重矩阵进行低秩分解,训练过程中只更新低秩部分的参数。 |

| 超参数 | 简单描述 |

|---|---|

| 迭代轮次 | 迭代轮次(epoch),控制训练过程中的迭代轮数。 |

| 批处理大小 | 批处理大小(Batchsize)表示在每次训练迭代中使用的样本数。较大的批处理大小可以加速训练,但可能会导致内存问题。 |

| 学习率 | 学习率(learning_rate)是在梯度下降的过程中更新权重时的超参数,过高会导致模型难以收敛,过低则会导致模型收敛速度过慢,平台已给出默认推荐值,可根据经验调整。 |

·ChatGLM2-6B

| 训练方法 | 简单描述 |

|---|---|

| 全量更新 | 全量更新在训练过程中对大模型的全部参数进行更新 |

| LoRA | 在固定预训练大模型本身的参数的基础上,在保留自注意力模块中原始权重矩阵的基础上,对权重矩阵进行低秩分解,训��练过程中只更新低秩部分的参数。 |

| 超参数 | 简单描述 |

|---|---|

| 迭代轮次 | 迭代轮次(epoch),控制训练过程中的迭代轮数。 |

| 批处理大小 | 批处理大小(Batchsize)表示在每次训练迭代中使用的样本数。较大的批处理大小可以加速训练,但可能会导致内存问题。 |

| 学习率 | 学习率(learning_rate)是在梯度下降的过程中更新权重时的超参数,过高会导致模型难以收敛,过低则会导致模型收敛速度过慢,平台已给出默认推荐值,可根据经验调整。 |

·Baichuan2-13B-Chat

| 训练方法 | 简单描述 |

|---|---|

| 全量更新 | 全量更新在训练过程中对大模型的全部参数进行更新 |

| LoRA | 在固定预训练大模型本身的参数的基础上,在保留自注意力模块中原始权重矩阵的基础上,对权重矩阵进行低秩分解,训练过程中只更新低秩部分的参数。 |

| 超参数 | 简单描述 |

|---|---|

| 迭代轮次 | 迭代轮次(epoch),控制训练过程中的迭代轮数。 |

| 学习率 | 学习率(learning_rate)是在梯度下降的过程中更新权重时的超参数,过高会导致模型难以收敛,过低则会导致模型收敛速度过慢,平台已给出默认推荐值,可根据经验调整。 |

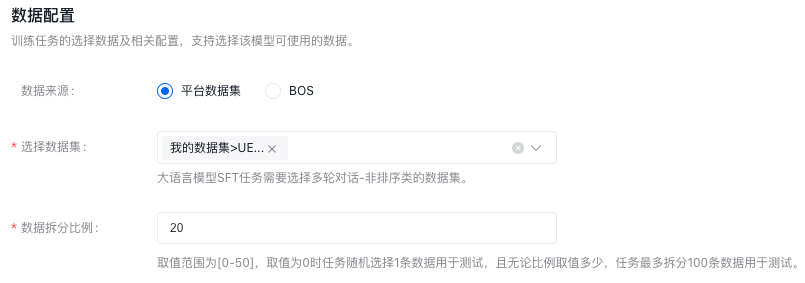

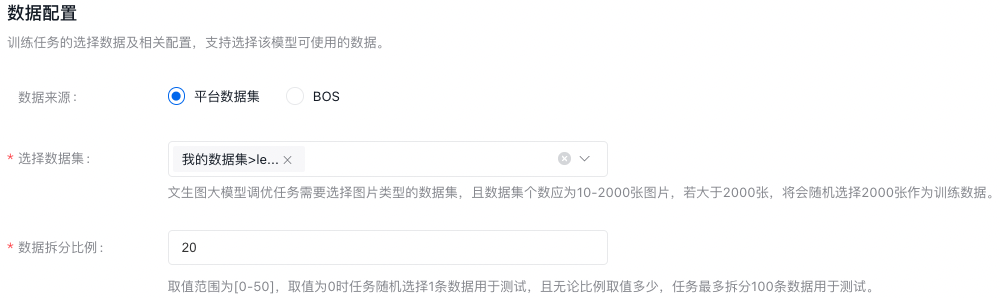

数据配置

数据拆分比例:比如设置20,则表示选定数据集版本总数的80%作为训练集,20%作为验证集。

文生图大模型

新建运行

进入模型训练的任务运行配置页,填写基本信息。

训练配置

开关打开后,需要选择SFT的基准模型,此模型来源于运行中的SFT任务。所以您开启增量训练任务的前提有已经在运行中的SFT任务。

·Stable_diffusion XL 1.0

| 训练方法 | 简单描述 |

|---|---|

| LoRA | 在固定预训练大模型本身的参数的基础上,在保留自注意力模块中原始权重矩阵的基础上,对权重矩阵进行低秩分解,训练过程中只更新低秩部分的参数。 |

| 超参数 | 简单描述 |

|---|---|

| 迭代轮次 | 迭代轮次(epoch),控制训练过程中的迭代轮数。 |

| 批处理大小 | 批处理大小(Batchsize)表示在每次训练迭代中使用的样本数。较大的批处理大小可以加速训练,但可能会导致内存问题。 |

| 学习率 | 学习率(learning_rate)是在梯度下降的过程中更新权重时的超参数,过高会导致模型难以收敛,过低则会导致模型收敛速度过慢,平台已给出默认推荐值,可根据经验调整。 |

数据配置

数据拆分比例:比如设置20,则表示选定数据集版本总数的80%作为训练集,20%作为验证集。

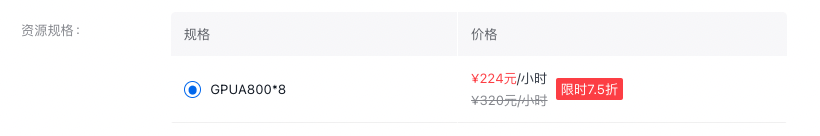

资源配置

修改于 2023-11-15 02:41:55